মেশিন লার্নিং (Machine Learning) -এর জগতে, বিশেষ করে ক্লাসিফিকেশন (Classification) সমস্যা সমাধানে, Gradient Boosting Classifier (GBC) একটি অত্যন্ত শক্তিশালী এবং জনপ্রিয় অ্যালগরিদম । এটি কেবল একটি মডেল নয়, বরং একাধিক দুর্বল মডেলের (weak learners) সম্মিলিত শক্তিকে কাজে লাগিয়ে নির্ভুল ভবিষ্যদ্বাণী করার একটি কৌশল । ডেটার জটিল প্যাটার্নগুলি ক্যাপচার করার ক্ষেত্রে Gradient Boosting বিশেষভাবে পারদর্শী, যা এটিকে বিভিন্ন ভবিষ্যদ্বাণীমূলক কাজে অত্যন্ত কার্যকর করে তোলে।

সাম্প্রতিক বছরগুলিতে, ডেটা সায়েন্স প্রতিযোগিতাগুলিতে, যেমন কাগল (Kaggle)-এ, গ্রেডিয়েন্ট বুস্টিং মডেলগুলির সাফল্যের কারণে এদের জনপ্রিয়তা আরও বৃদ্ধি পেয়েছে । এটি মেশিন লার্নিং অনুশীলনকারীদের জন্য একটি অপরিহার্য দক্ষতা হয়ে উঠেছে।

এই ব্লগ পোস্টে, আমরা Gradient Boosting Classifier কী, এটি কীভাবে কাজ করে, পাইথনে এর ব্যবহারিক প্রয়োগ, এর সুবিধা-অসুবিধা এবং কখন এটি ব্যবহার করা উচিত, সে সম্পর্কে বিস্তারিতভাবে আলোচনা করব। এই আলোচনাটি মেশিন লার্নিং শিখছেন এমন প্রত্যেকের জন্য একটি সুস্পষ্ট এবং ব্যবহারিক নির্দেশিকা হিসেবে কাজ করবে।

গ্রেডিয়েন্ট বুস্টিং ক্লাসিফায়ার (Gradient Boosting)-এর মূল সংজ্ঞা ও উদ্দেশ্য

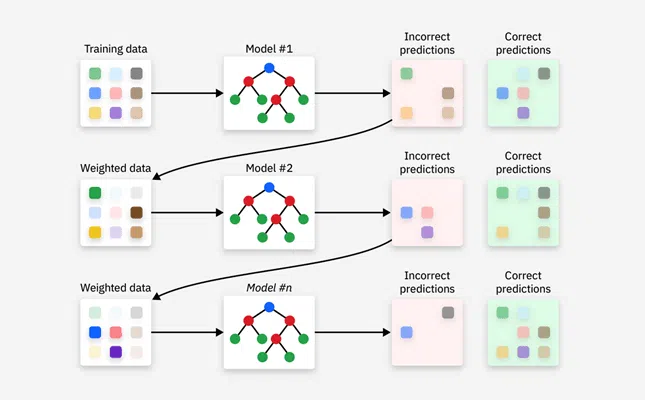

Gradient Boosting হলো একটি মেশিন লার্নিং কৌশল যা একাধিক দুর্বল ভবিষ্যদ্বাণীমূলক মডেলকে (সাধারণত ডিসিশন ট্রি) একটি একক শক্তিশালী এনসেম্বল মডেলে একত্রিত করে । এই দুর্বল মডেলগুলিকে পর্যায়ক্রমে প্রশিক্ষণ দেওয়া হয় যাতে তারা পূর্ববর্তী মডেলগুলির দ্বারা করা ভুলগুলিকে (residuals বা pseudo-residuals) কমিয়ে আনতে পারে এবং ভবিষ্যদ্বাণীর নির্ভুলতা উন্নত করতে পারে।

“Gradient” শব্দটি এসেছে এই সত্য থেকে যে, অ্যালগরিদমটি একটি লস ফাংশন (loss function) বা ত্রুটি ফাংশনকে সর্বনিম্ন করার জন্য গ্রেডিয়েন্ট ডিসেন্ট (Gradient Descent) অপ্টিমাইজেশন কৌশল ব্যবহার করে । এটি পুনরাবৃত্তিমূলকভাবে এমন একটি ফাংশন (দুর্বল হাইপোথিসিস) নির্বাচন করে যা লস ফাংশনের নেগেটিভ গ্রেডিয়েন্টের দিকে নির্দেশ করে, অর্থাৎ যেদিকে ভুল সবচেয়ে দ্রুত কমে। Gradient Boosting-এর এই নমনীয়তা এটিকে যেকোনো ডিফারেনশিয়েবল লস ফাংশন (differentiable loss function) অপ্টিমাইজ করার ক্ষমতা দেয়।

এর মূল উদ্দেশ্য হলো, ডেটার জটিল প্যাটার্নগুলি ক্যাপচার করে উচ্চ নির্ভুলতার সাথে ভবিষ্যদ্বাণী করা। এটি ক্লাসিফিকেশন (Classification), রিগ্রেশন (Regression) এবং র্যাঙ্কিং (Ranking) সহ বিভিন্ন ভবিষ্যদ্বাণীমূলক কাজে অত্যন্ত কার্যকর । লস ফাংশনের গ্রেডিয়েন্ট ব্যবহার করে ত্রুটিগুলি সংশোধন করার পদ্ধতিটি নিশ্চিত করে যে প্রতিটি নতুন মডেল পূর্ববর্তী মডেলগুলির দুর্বলতাগুলিকে সুনির্দিষ্টভাবে লক্ষ্য করে, যার ফলে সামগ্রিক মডেলের কর্মক্ষমতা ক্রমাগত উন্নত হয়।

কীভাবে গ্রেডিয়েন্ট বুস্টিং ক্লাসিফায়ার কাজ করে?

Gradient Boosting একটি পুনরাবৃত্তিমূলক প্রক্রিয়া অনুসরণ করে, যেখানে প্রতিটি নতুন দুর্বল মডেল পূর্ববর্তী মডেলগুলির ভুলগুলি সংশোধন করে। একটি সহজ উদাহরণের মাধ্যমে এর ধাপগুলি বোঝা যাক। শিক্ষক যেমন শিক্ষার্থীদের দুর্বলতা চিহ্নিত করে সেগুলিতে মনোযোগ দেন, Gradient Boosting অ্যালগরিদমও তেমনি পূর্ববর্তী মডেলগুলির ভুলগুলি থেকে শিখে এবং প্রতিটি ধাপে নিজেকে উন্নত করে । ধাপে ধাপে অ্যালগরিদম তৈরির প্রক্রিয়া

ধাপ ১: প্রাথমিক অনুমান (Initial Prediction):

অ্যালগরিদম একটি খুব সাধারণ মডেল দিয়ে শুরু হয়। ক্লাসিফিকেশন সমস্যার জন্য, এটি সাধারণত টার্গেট ক্লাসের গড় বা সবচেয়ে ঘন ঘন ক্লাস (most frequent class) হতে পারে। রিগ্রেশন সমস্যার জন্য, এটি টার্গেট ভেরিয়েবলের গড় মান (mean of the target variable) দিয়ে শুরু হয় । এই প্রাথমিক অনুমানটিই আমাদের প্রথম মডেল।

উদাহরণস্বরূপ, যদি আমরা শিক্ষার্থীদের পরীক্ষার স্কোর ভবিষ্যদ্বাণী করতে চাই, তাহলে প্রথম অনুমান হবে সকল শিক্ষার্থীর গড় স্কোর। যদি গড় স্কোর ৭০ হয়, তাহলে প্রাথমিক মডেলটি প্রতিটি শিক্ষার্থীর জন্য ৭০ স্কোর ভবিষ্যদ্বাণী করবে । এই প্রাথমিক অনুমানটি লস ফাংশনের গ্রেডিয়েন্টকে শূন্য করে এমন একটি মান খুঁজে বের করার প্রথম ধাপ ।

ধাপ ২: রেসিডিউয়াল বা ছদ্ম-রেসিডিউয়াল গণনা (Calculating Residuals/Pseudo-Residuals):

পরবর্তী ধাপে, প্রতিটি ডেটা পয়েন্টের জন্য বর্তমান মডেলের ভবিষ্যদ্বাণী এবং আসল মানের মধ্যে পার্থক্য (error) গণনা করা হয়। এই পার্থক্যকে “রেসিডিউয়াল” (residuals) বা “ছদ্ম-রেসিডিউয়াল” (pseudo-residuals) বলা হয় । Gradient Boosting-এর ক্ষেত্রে, এই ছদ্ম-রেসিডিউয়ালগুলি লস ফাংশনের নেগেটিভ গ্রেডিয়েন্ট (negative gradient) হিসাবে কাজ করে ।

উদাহরণস্বরূপ, যদি একজন শিক্ষার্থীর আসল স্কোর ৮০ হয় এবং বর্তমান ভবিষ্যদ্বাণী ৭০ হয়, তাহলে রেসিডিউয়াল হবে ১০ (৮০-৭০)। এই রেসিডিউয়ালগুলিই হলো সেই “ভুল” যা পরবর্তী মডেলকে শিখতে হবে । এই রেসিডিউয়ালগুলি কেবল ত্রুটির পরিমাণই নয়, বরং ত্রুটির দিকনির্দেশও নির্দেশ করে, যা মডেলকে কোন দিকে সংশোধন করতে হবে তা জানায় ।

ধাপ ৩: রেসিডিউয়াল-এর উপর নতুন উইক লার্নার প্রশিক্ষণ (Training New Weak Learner on Residuals):

এখন, একটি নতুন দুর্বল লার্নার (সাধারণত একটি ডিসিশন ট্রি) এই রেসিডিউয়ালগুলিকে টার্গেট ভেরিয়েবল হিসাবে ব্যবহার করে প্রশিক্ষণপ্রাপ্ত হয় । অর্থাৎ, এই নতুন ট্রি-এর লক্ষ্য হলো পূর্ববর্তী মডেলের ভুলগুলি ভবিষ্যদ্বাণী করা। এই ট্রি ডেটা পয়েন্টগুলিকে এমনভাবে বিভক্ত করে যাতে প্রতিটি পাতার নোড (leaf node) সেই অঞ্চলের রেসিডিউয়াল ত্রুটি সর্বনিম্ন করে । এই প্রক্রিয়াটি নিশ্চিত করে যে নতুন ট্রি পূর্ববর্তী মডেলের ত্রুটিপূর্ণ ক্ষেত্রগুলিতে মনোযোগ দেয়।

ধাপ ৪: মডেল আপডেট (Updating the Model):

নতুন প্রশিক্ষিত দুর্বল লার্নারের ভবিষ্যদ্বাণীগুলি একটি “লার্নিং রেট” (learning rate) বা “শ্রিঙ্কেজ” (shrinkage) দ্বারা গুণ করে বর্তমান মডেলের ভবিষ্যদ্বাণীর সাথে যোগ করা হয় । লার্নিং রেট হলো ০ থেকে ১-এর মধ্যে একটি ছোট মান (যেমন ০.১), যা প্রতিটি নতুন ট্রি-এর অবদানকে নিয়ন্ত্রণ করে । এটি মডেলকে ধীরে ধীরে শিখতে সাহায্য করে, যা ওভারফিটিং প্রতিরোধে অত্যন্ত গুরুত্বপূর্ণ ।

যদি লার্নিং রেট খুব বেশি হয়, তাহলে মডেল দ্রুত শিখতে পারে কিন্তু ওভারফিট হওয়ার ঝুঁকি বাড়ে। একটি ছোট লার্নিং রেট মডেলকে আরও শক্তিশালী এবং সাধারণীকরণযোগ্য (generalized) করে তোলে, যদিও এতে প্রশিক্ষণের সময় বেশি লাগতে পারে ।

ধাপ ৫: পুনরাবৃত্তি এবং লার্নিং রেট (Iteration and Learning Rate/Shrinkage):

ধাপ ২ থেকে ৪ পুনরাবৃত্তি করা হয় একটি নির্দিষ্ট সংখ্যক ইটারেশন (iterations) বা n_estimators পর্যন্ত, অথবা যতক্ষণ না লস ফাংশন আর উল্লেখযোগ্যভাবে হ্রাস না পায় (আর্লি স্টপিং) । প্রতিটি ইটারেশনে, একটি নতুন ট্রি পূর্ববর্তী মডেলের অবশিষ্ট ত্রুটিগুলি ভবিষ্যদ্বাণী করে এবং লার্নিং রেট দ্বারা স্কেল করে সামগ্রিক মডেলে যোগ করা হয়। এই প্রক্রিয়াটি চলতে থাকে যতক্ষণ না একটি শক্তিশালী এবং নির্ভুল মডেল তৈরি হয় । লার্নিং রেট এবং n_estimators এর মধ্যে একটি ট্রেড-অফ (trade-off) রয়েছে: কম লার্নিং রেটের জন্য সাধারণত বেশি n_estimators প্রয়োজন হয় ।

লস ফাংশন এবং গ্রেডিয়েন্টের ভূমিকা

লস ফাংশন (Loss Function) হলো মেশিন লার্নিং-এর একটি গুরুত্বপূর্ণ উপাদান যা মডেলের ভবিষ্যদ্বাণী এবং আসল মানের মধ্যে পার্থক্য পরিমাপ করে । এটি মডেলের কর্মক্ষমতা কতটা ভালো তা নির্ধারণ করে এবং মডেলকে প্রশিক্ষণের সময় তার অভ্যন্তরীণ কাঠামো এবং কনফিগারেশন আপডেট করার জন্য একটি নির্দেশিকা হিসাবে কাজ করে, যাতে লস ফাংশনের মান সর্বনিম্ন হয়।

Gradient Boosting-এ, লস ফাংশন অবশ্যই ডিফারেনশিয়েবল (differentiable) হতে হবে । ক্লাসিফিকেশন অ্যালগরিদমগুলির জন্য সাধারণত লগারিদমিক লস (logarithmic loss বা log-loss) ব্যবহার করা হয়, যেখানে রিগ্রেশন অ্যালগরিদমগুলি স্কোয়ার্ড এরর (squared errors) বা মিন স্কোয়ার্ড এরর (Mean Squared Error – MSE) ব্যবহার করতে পারে।

“গ্রেডিয়েন্ট” শব্দটি লস ফাংশনের ডেরিভেটিভ (derivative) বা ঢালকে বোঝায় । গ্রেডিয়েন্ট ডিসেন্ট (Gradient Descent) হলো একটি অপ্টিমাইজেশন অ্যালগরিদম যা লস ফাংশনকে সর্বনিম্ন করার জন্য পুনরাবৃত্তিমূলকভাবে মডেলের প্যারামিটারগুলি আপডেট করে। Gradient Boosting-এ, এই গ্রেডিয়েন্টগুলিই হলো ছদ্ম-রেসিডিউয়াল । যখন একটি নতুন দুর্বল মডেল এই ছদ্ম-রেসিডিউয়ালগুলির উপর প্রশিক্ষিত হয়, তখন এটি মূলত লস ফাংশনের নেগেটিভ গ্রেডিয়েন্টের দিকে মডেলকে “ধাক্কা” দেয়, যার ফলে ত্রুটিগুলি হ্রাস পায় । এই গাণিতিক ভিত্তিই Gradient Boosting-কে এত শক্তিশালী এবং কার্যকর করে তোলে, কারণ এটি ত্রুটি সংশোধনের একটি সুনির্দিষ্ট এবং অপ্টিমাইজড পথ অনুসরণ করে।

পাইথন ব্যবহার করে Gradient Boosting -এর উদাহরণ

পাইথনে Gradient Boosting Classifier প্রয়োগ করা Scikit-learn লাইব্রেরির মাধ্যমে তুলনামূলকভাবে সহজ। এখানে একটি ধারণাগত উদাহরণ এবং গুরুত্বপূর্ণ প্যারামিটারগুলির ব্যাখ্যা দেওয়া হলো।

মেশিন লার্নিং মডেল প্রশিক্ষণের আগে ডেটা প্রিপ্রসেসিং (data preprocessing) অত্যন্ত গুরুত্বপূর্ণ। Gradient Boosting অ্যালগরিদম অনুপস্থিত ডেটা (missing data) এবং বিভিন্ন ধরণের ফিচার (feature) নিয়ে কাজ করতে পারলেও , ডেটা পরিষ্কার করা, রূপান্তর করা এবং মডেলিংয়ের জন্য প্রস্তুত করা মডেলের কর্মক্ষমতা উন্নত করতে পারে । এর মধ্যে অনুপস্থিত মানগুলি পূরণ করা (যেমন গড় বা মধ্যমা ব্যবহার করে), আউটলায়ার (outliers) সনাক্ত করা এবং পরিচালনা করা, ক্যাটাগরিক্যাল ভেরিয়েবলগুলিকে সংখ্যায় রূপান্তর করা (যেমন ওয়ান-হট এনকোডিং) এবং ফিচারগুলিকে স্কেল করা (scaling) অন্তর্ভুক্ত।

একটি সাধারণ ক্লাসিফিকেশন সমস্যার জন্য, যেমন টাইটানিক ডেটাসেটে যাত্রীদের বেঁচে থাকার ভবিষ্যদ্বাণী করা, sklearn.ensemble.GradientBoostingClassifier ব্যবহার করা যেতে পারে । মডেলটি ফিট (fit) করার পর, এটি নতুন ডেটার উপর ভবিষ্যদ্বাণী করতে পারে এবং বিভিন্ন মেট্রিক্স (metrics) ব্যবহার করে এর কর্মক্ষমতা মূল্যায়ন করা যেতে পারে ।

|

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 |

# প্রয়োজনীয় লাইব্রেরি আমদানি (Import necessary libraries) from sklearn.ensemble import GradientBoostingClassifier from sklearn.model_selection import train_test_split from sklearn.metrics import accuracy_score import pandas as pd import numpy as np # উদাহরণ ডেটাসেট তৈরি (Creating a sample dataset) # বাস্তব ক্ষেত্রে, আপনি আপনার নিজস্ব ডেটাসেট লোড করবেন data = { 'Feature1': np.random.rand(100), 'Feature2': np.random.rand(100) * 10, 'Feature3': np.random.randint(0, 2, 100), 'Target': np.random.randint(0, 2, 100) # 0 বা 1 ক্লাসিফিকেশন } df = pd.DataFrame(data) X = df[['Feature1', 'Feature2', 'Feature3']] y = df # ডেটাসেটকে প্রশিক্ষণ এবং পরীক্ষার সেটে বিভক্ত করা (Splitting the dataset into training and testing sets) X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42) # GradientBoostingClassifier মডেল তৈরি এবং প্রশিক্ষণ (Creating and training the GradientBoostingClassifier model) # এখানে কিছু সাধারণ প্যারামিটার ব্যবহার করা হয়েছে gb_classifier = GradientBoostingClassifier( n_estimators=100, # বুস্টিং স্টেজের সংখ্যা learning_rate=0.1, # প্রতিটি ট্রি-এর অবদান max_depth=3, # প্রতিটি ট্রি-এর সর্বোচ্চ গভীরতা subsample=1.0, # প্রতিটি ট্রি প্রশিক্ষণের জন্য ব্যবহৃত নমুনার ভগ্নাংশ random_state=42 # ফলাফলের পুনরাবৃত্তি নিশ্চিত করতে ) gb_classifier.fit(X_train, y_train) # ভবিষ্যদ্বাণী করা (Making predictions) y_pred = gb_classifier.predict(X_test) # মডেলের নির্ভুলতা মূল্যায়ন (Evaluating the model's accuracy) accuracy = accuracy_score(y_test, y_pred) print(f"মডেলের নির্ভুলতা: {accuracy:.2f}") # অন্যান্য প্যারামিটার এবং টিউনিং (Other parameters and tuning) # মডেলের কর্মক্ষমতা আরও উন্নত করতে GridSearchCV বা RandomizedSearchCV ব্যবহার করা যেতে পারে |

এই প্যারামিটারগুলি যত্ন সহকারে টিউন করা Gradient Boosting মডেলের সর্বোত্তম কর্মক্ষমতা অর্জনের জন্য অপরিহার্য। গ্রিড সার্চ (Grid Search), র্যান্ডম সার্চ (Random Search) বা বেসিয়ান অপ্টিমাইজেশন (Bayesian Optimization) এর মতো কৌশলগুলি হাইপারপ্যারামিটার টিউনিং-এর জন্য ব্যবহার করা যেতে পারে ।

Gradient Boosting Classifier-এর গুরুত্বপূর্ণ প্যারামিটার

Gradient Boosting Classifier-এর কর্মক্ষমতা অপ্টিমাইজ করার জন্য এর হাইপারপ্যারামিটার (hyperparameters) টিউন করা অত্যন্ত গুরুত্বপূর্ণ । এখানে কিছু গুরুত্বপূর্ণ প্যারামিটার এবং তাদের ভূমিকা আলোচনা করা হলো:

| প্যারামিটার নাম | বর্ণনা | প্রভাব |

| n_estimators | বুস্টিং স্টেজের সংখ্যা বা তৈরি করা ডিসিশন ট্রি-এর মোট সংখ্যা। | সাধারণত, একটি বড় সংখ্যা ভালো পারফরম্যান্স দেয়, তবে খুব বেশি হলে ওভারফিটিং হতে পারে। |

| learning_rate | প্রতিটি ট্রি-এর অবদানকে সংকুচিত করে। | ছোট মান মডেলকে ধীরে ধীরে শিখতে সাহায্য করে, যা ওভারফিটিং কমায় এবং মডেলকে আরও শক্তিশালী করে। তবে এতে প্রশিক্ষণের সময় বাড়ে। n_estimators-এর সাথে এর একটি ট্রেড-অফ আছে। |

| max_depth | প্রতিটি পৃথক ডিসিশন ট্রি-এর সর্বোচ্চ গভীরতা। | এটি ট্রি-এর জটিলতা নিয়ন্ত্রণ করে। কম গভীরতা ওভারফিটিং কমাতে সাহায্য করে। ডেটার মিথস্ক্রিয়ার (interaction) উপর নির্ভর করে সেরা মান পরিবর্তিত হয়। |

| subsample | প্রতিটি ট্রি প্রশিক্ষণের জন্য ব্যবহৃত নমুনার (samples) ভগ্নাংশ। | যদি ১.০ এর কম হয়, তবে এটি স্টোকাস্টিক গ্রেডিয়েন্ট বুস্টিং (Stochastic Gradient Boosting) তৈরি করে, যা ভ্যারিয়েন্স কমায় এবং ওভারফিটিং প্রতিরোধে সাহায্য করে। |

| random_state | র্যান্ডম নম্বর জেনারেটরের জন্য ব্যবহৃত বীজ। | এটি মডেলের ফলাফলগুলির পুনরাবৃত্তি নিশ্চিত করে। |

| loss | অপ্টিমাইজ করার জন্য লস ফাংশন। | ক্লাসিফিকেশনের জন্য ‘deviance’ (লজিস্টিক রিগ্রেশন) বা ‘exponential’ (AdaBoost-এর জন্য) ব্যবহার করা হয়। |

| min_samples_split | একটি অভ্যন্তরীণ নোডকে বিভক্ত করার জন্য প্রয়োজনীয় নমুনার সর্বনিম্ন সংখ্যা। | এটি ট্রি-এর বৃদ্ধি নিয়ন্ত্রণ করে এবং ওভারফিটিং প্রতিরোধে সাহায্য করে। |

| min_samples_leaf | একটি পাতার নোডে (leaf node) থাকার জন্য প্রয়োজনীয় নমুনার সর্বনিম্ন সংখ্যা। | এটিও ট্রি-এর বৃদ্ধি নিয়ন্ত্রণ করে এবং ওভারফিটিং প্রতিরোধে সহায়ক। |

| max_features | সেরা বিভাজন (split) খোঁজার সময় বিবেচনা করার জন্য ফিচারগুলির (features) সংখ্যা। | এটি ভ্যারিয়েন্স কমাতে এবং পক্ষপাত বাড়াতে সাহায্য করে। |

| max_leaf_nodes | সেরা-প্রথম ফ্যাশনে (best-first fashion) ট্রি-এর সর্বোচ্চ পাতার নোড। | এটি ট্রি-এর জটিলতা নিয়ন্ত্রণ করে। max_depth এর সাথে এর সম্পর্ক রয়েছে। |

| n_iter_no_change | আর্লি স্টপিং (early stopping) এর জন্য ব্যবহৃত হয়। | যদি একটি নির্দিষ্ট সংখ্যক ইটারেশন ধরে ভ্যালিডেশন স্কোর (validation score) উন্নত না হয়, তাহলে প্রশিক্ষণ বন্ধ করে দেয়। এটি ওভারফিটিং প্রতিরোধে কার্যকর। |

সুবিধা ও অসুবিধা

Gradient Boosting Classifier তার উচ্চ নির্ভুলতার জন্য পরিচিত হলেও, এর কিছু সুবিধা এবং অসুবিধাও রয়েছে যা বিবেচনা করা প্রয়োজন।

| সুবিধা (Advantages) | অসুবিধা (Disadvantages) |

| উচ্চ ভবিষ্যদ্বাণীমূলক নির্ভুলতা: এটি প্রায়শই অন্যান্য অ্যালগরিদমগুলির চেয়ে ভালো পারফর্ম করে, বিশেষ করে জটিল ডেটাসেটে। | ওভারফিটিং প্রবণতা: এটি ক্রমাগত সমস্ত ত্রুটি কমাতে চায়, যা আউটলায়ারগুলির (outliers) উপর অতিরিক্ত জোর দিতে পারে এবং সঠিক রেগুলারাইজেশন ছাড়া ওভারফিটিং ঘটাতে পারে। |

| নমনীয়তা: এটি রিগ্রেশন, ক্লাসিফিকেশন এবং র্যাঙ্কিং সহ বিভিন্ন সমস্যার জন্য অভিযোজিত হতে পারে। এটি বিভিন্ন ডিফারেনশিয়েবল লস ফাংশন অপ্টিমাইজ করতে পারে। | গণনামূলকভাবে ব্যয়বহুল/দীর্ঘ প্রশিক্ষণ সময়: মডেলগুলি পর্যায়ক্রমে তৈরি হয় এবং প্রায়শই প্রচুর সংখ্যক ট্রি (১০০০-এর বেশি) প্রয়োজন হয়, যা প্রশিক্ষণকে সময় এবং মেমরি-নিবিড় করে তোলে। |

| নন-লিনিয়ার ডেটা হ্যান্ডেল করতে পারে: একাধিক ট্রি একত্রিত করার মাধ্যমে, Gradient Boosting ডেটার মধ্যে জটিল নন-লিনিয়ার সম্পর্কগুলি মডেল করতে পারে। | টিউনিং-এ জটিলতা: এর উচ্চ নমনীয়তার সাথে একটি অসুবিধা হলো: অনেক প্যারামিটার একে অপরের সাথে মিথস্ক্রিয়া করে এবং পদ্ধতির আচরণকে উল্লেখযোগ্যভাবে প্রভাবিত করে (যেমন, ইটারেশনের সংখ্যা, ট্রি গভীরতা, রেগুলারাইজেশন প্যারামিটার)। এর জন্য পুঙ্খানুপুঙ্খ হাইপারপ্যারামিটার টিউনিং প্রয়োজন। |

| অনুপস্থিত ডেটা হ্যান্ডেল করে: অ্যালগরিদম অনুপস্থিত ডেটা পরিচালনা করতে পারে, যার জন্য স্পষ্ট ইম্পুটেশনের (imputation) প্রয়োজন হয় না। | কম ব্যাখ্যাযোগ্য (Less Interpretable): সরল মডেলগুলির তুলনায় Gradient Boosting মডেলগুলি কম ব্যাখ্যাযোগ্য হতে পারে, যদিও বিভিন্ন ব্যাখ্যাযোগ্যতা সরঞ্জাম (interpretability tools) ব্যবহার করে এটি কিছুটা কমানো যেতে পারে। |

| ট্যাবুলার ডেটায় ভালো পারফরম্যান্স: কাঠামোগত ডেটাসেটে এটি খুব কার্যকর। | আউটলায়ারগুলির প্রতি সংবেদনশীল: ডেটাসেটে আউটলায়ারের উপস্থিতি দ্বারা অ্যালগরিদম নেতিবাচকভাবে প্রভাবিত হতে পারে। |

| ভারসাম্যহীন ডেটাসেট হ্যান্ডেল করে: এটি ভারসাম্যহীন ডেটাসেটগুলিকে আরও কার্যকরভাবে পরিচালনা করতে পারে, কারণ এটি ভুল শ্রেণীবদ্ধ উদাহরণগুলিতে বেশি মনোযোগ দেয়। |

এই সুবিধা এবং অসুবিধাগুলি বোঝা গুরুত্বপূর্ণ, কারণ এটি Gradient Boosting Classifier কখন ব্যবহার করা উচিত এবং কখন অন্যান্য অ্যালগরিদমগুলি আরও উপযুক্ত হতে পারে, তা নির্ধারণে সহায়তা করে। এর উচ্চ নির্ভুলতা প্রায়শই এর গণনামূলক ব্যয় এবং টিউনিং-এর জটিলতাকে ন্যায্যতা দেয়, বিশেষ করে যখন ডেটাসেট জটিল হয় এবং নির্ভুলতা সর্বোচ্চ অগ্রাধিকার পায়।

কখন Gradient Boosting Classifier ব্যবহার করবেন?

Gradient Boosting Classifier একটি অত্যন্ত শক্তিশালী অ্যালগরিদম, তবে এর সর্বোত্তম ব্যবহার নির্ভর করে নির্দিষ্ট সমস্যার প্রকৃতি এবং উপলব্ধ সংস্থানগুলির উপর।

Gradient Boosting Classifier নিম্নলিখিত পরিস্থিতিতে বিশেষভাবে কার্যকর:

- যখন উচ্চ নির্ভুলতা অত্যন্ত গুরুত্বপূর্ণ: যদি আপনার প্রকল্পের জন্য সর্বোচ্চ সম্ভাব্য ভবিষ্যদ্বাণীমূলক নির্ভুলতা প্রয়োজন হয়, তাহলে Gradient Boosting একটি চমৎকার পছন্দ। এটি প্রায়শই ডেটা সায়েন্স প্রতিযোগিতাগুলিতে বিজয়ী মডেলগুলির ভিত্তি হয় ।

- জটিল ডেটাসেটের জন্য: যেখানে ফিচার এবং লেবেলগুলির মধ্যে সম্পর্ক জটিল এবং নন-লিনিয়ার, সেখানে Gradient Boosting মডেলগুলি ডেটার জটিল প্যাটার্নগুলি কার্যকরভাবে ক্যাপচার করতে পারে ।

- ভারসাম্যহীন ডেটা (Imbalanced Data) হ্যান্ডেল করার জন্য: Gradient Boosting ভারসাম্যহীন ডেটাসেটগুলিকে আরও কার্যকরভাবে পরিচালনা করতে পারে, কারণ এটি ভুল শ্রেণীবদ্ধ উদাহরণগুলিতে বেশি মনোযোগ দেয় ।

- যখন হাইপারপ্যারামিটার টিউনিং-এর জন্য সময় এবং গণনামূলক সংস্থান উপলব্ধ থাকে: Gradient Boosting-এর জন্য যত্নশীল টিউনিং প্রয়োজন। যদি আপনার কাছে মডেল অপ্টিমাইজ করার জন্য পর্যাপ্ত সময় এবং কম্পিউটেশনাল রিসোর্স থাকে, তাহলে এটি সেরা ফলাফল দিতে পারে ।

Gradient Boosting-এর ব্যবহারিক প্রয়োগগুলির মধ্যে রয়েছে:

- জালিয়াতি সনাক্তকরণ (Fraud Detection): ক্রেডিট কার্ড জালিয়াতি বা অন্যান্য আর্থিক জালিয়াতি সনাক্তকরণে এর উচ্চ নির্ভুলতা অত্যন্ত মূল্যবান ।

- সুপারিশ সিস্টেম (Recommendation Systems): ব্যবহারকারীদের পছন্দ অনুযায়ী পণ্য বা বিষয়বস্তু সুপারিশ করতে এটি ব্যবহৃত হয় ।

- চিকিৎসা নির্ণয় (Medical Diagnosis): রোগীর ডেটার উপর ভিত্তি করে রোগ নির্ণয় বা হাসপাতালের পুনঃভর্তির হার ভবিষ্যদ্বাণী করতে এটি প্রয়োগ করা হয় ।

- আর্থিক পূর্বাভাস (Financial Forecasting): স্টক মূল্য বা আর্থিক বাজারের প্রবণতা ভবিষ্যদ্বাণী করতে এর ব্যবহার দেখা যায় ।

- বাড়ির মূল্য ভবিষ্যদ্বাণী (Predicting House Prices): অবস্থান, আকার এবং সুযোগ-সুবিধার মতো বিভিন্ন ফিচারের উপর ভিত্তি করে বাড়ির মূল্য অনুমান করতে এটি কার্যকর ।

- র্যাঙ্কিং (Ranking): সার্চ ইঞ্জিনগুলিতে ফলাফল র্যাঙ্ক করতে এর ভ্যারিয়েন্ট ব্যবহার করা হয় ।

- হাই এনার্জি ফিজিক্স (High Energy Physics): লার্জ হ্যাড্রন কলাইডার (LHC)-এর মতো ক্ষেত্রে ডেটা বিশ্লেষণে এর প্রয়োগ দেখা গেছে ।

অন্যান্য অ্যালগরিদম (যেমন Random Forest, XGBoost, LightGBM) এর সাথে তুলনামূলক আলোচনা

Gradient Boosting Classifier-এর কার্যকারিতা বোঝার জন্য, অন্যান্য জনপ্রিয় এনসেম্বল অ্যালগরিদমগুলির সাথে এর তুলনামূলক আলোচনা সহায়ক হতে পারে।

বনাম Random Forest:

নির্ভুলতা: Gradient Boosting প্রায়শই Random Forest-এর চেয়ে উচ্চতর ভবিষ্যদ্বাণীমূলক নির্ভুলতা অর্জন করে, বিশেষ করে যখন ডেটাসেট তুলনামূলকভাবে ছোট এবং পরিষ্কার হয় ।

ওভারফিটিং: Random Forest ব্যাগিং পদ্ধতির কারণে ওভারফিটিং-এর প্রতি কম সংবেদনশীল । Gradient Boosting, তার ক্রমিক প্রকৃতির কারণে, ওভারফিটিং-এর প্রতি বেশি সংবেদনশীল হতে পারে, বিশেষ করে যদি অতিরিক্ত ট্রি ব্যবহার করা হয় বা ডেটা নয়েজি হয় ।

প্রশিক্ষণের সময়: Random Forest প্রতিটি ট্রি স্বাধীনভাবে প্রশিক্ষণ দেয়, যা সমান্তরাল প্রক্রিয়াকরণের (parallel processing) সুযোগ দেয় এবং প্রশিক্ষণের সময় দ্রুত করে । Gradient Boosting-এর ক্রমিক প্রকৃতির কারণে প্রশিক্ষণের সময় বেশি লাগে, কারণ প্রতিটি ট্রি পূর্ববর্তীটির উপর নির্ভরশীল ।

ব্যাখ্যাযোগ্যতা (Interpretability): Random Forest সাধারণত Gradient Boosting-এর চেয়ে বেশি ব্যাখ্যাযোগ্য, কারণ প্রতিটি ট্রি স্বাধীনভাবে কাজ করে এবং ফিচার ইম্পর্টেন্স (feature importance) সহজেই পাওয়া যায় ।

কখন ব্যবহার করবেন: যদি গতি, স্কেলেবিলিটি এবং ওভারফিটিং-এর ঝুঁকি কমানো আপনার প্রধান লক্ষ্য হয়, তাহলে Random Forest ভালো বিকল্প। যদি সর্বোচ্চ নির্ভুলতা প্রয়োজন হয় এবং আপনি হাইপারপ্যারামিটার টিউনিং-এর জন্য সময় দিতে ইচ্ছুক হন, তাহলে Gradient Boosting একটি সুবিধা দিতে পারে ।

বনাম AdaBoost:

AdaBoost হলো প্রথম দিকের একটি বুস্টিং অ্যালগরিদম যা এক্সপোনেনশিয়াল লস ফাংশন ব্যবহার করে । এটি সাধারণত ডিসিশন স্টাম্প (decision stumps) ব্যবহার করে । Gradient Boosting AdaBoost-এর একটি সাধারণীকরণ, যা যেকোনো ডিফারেনশিয়েবল লস ফাংশন অপ্টিমাইজ করার অনুমতি দেয় । এটি সাধারণত AdaBoost-এর চেয়ে ভালো পারফর্ম করে, বিশেষ করে যখন ডেটাসেটে আউটলায়ার থাকে, কারণ AdaBoost এক্সপোনেনশিয়াল লসের কারণে আউটলায়ারের প্রতি সংবেদনশীল ।

বনাম XGBoost:

XGBoost (Extreme Gradient Boosting) হলো Gradient Boosted Decision Trees-এর একটি অত্যন্ত অপ্টিমাইজড এবং জনপ্রিয় বাস্তবায়ন । এটি গতি এবং কর্মক্ষমতার জন্য ডিজাইন করা হয়েছে ।

গতি ও স্কেলেবিলিটি: XGBoost ঐতিহ্যবাহী Gradient Boosting বাস্তবায়নের চেয়ে উল্লেখযোগ্যভাবে দ্রুত, বিশেষ করে বড় ডেটাসেটে, কারণ এটি সমান্তরাল প্রক্রিয়াকরণ এবং GPU ত্বরণ সমর্থন করে ।

রেগুলারাইজেশন: XGBoost L1 এবং L2 রেগুলারাইজেশন সহ উন্নত রেগুলারাইজেশন কৌশলগুলি অন্তর্ভুক্ত করে, যা ওভারফিটিং প্রতিরোধে কার্যকর । এটি আর্লি স্টপিং (early stopping) এবং অনুপস্থিত মান (missing values) হ্যান্ডেল করার জন্য অন্তর্নির্মিত সমর্থনও প্রদান করে ।

কখন ব্যবহার করবেন: যদি আপনি বড় ডেটাসেট নিয়ে কাজ করেন, সময়সীমা কঠোর হয় এবং উচ্চ গতি ও স্কেলেবিলিটি প্রয়োজন হয়, তাহলে XGBoost সুস্পষ্ট বিজয়ী । Scikit-learn-এর GradientBoostingClassifier ছোট ডেটাসেট বা দ্রুত প্রোটোটাইপিংয়ের জন্য ভালো, যেখানে সরলতা এবং ব্যাখ্যাযোগ্যতা অগ্রাধিকার পায় ।

বনাম LightGBM:

LightGBM হলো Gradient Boosting-এর আরেকটি আধুনিক এবং অত্যন্ত দ্রুত বাস্তবায়ন।

গতি ও মেমরি: LightGBM একটি হিস্টোগ্রাম-ভিত্তিক অ্যালগরিদম ব্যবহার করে, যা XGBoost-এর চেয়েও দ্রুত প্রশিক্ষণ দেয় এবং কম মেমরি ব্যবহার করে । এটি লিফ-ওয়াইজ (leaf-wise) বৃদ্ধি কৌশল ব্যবহার করে, যা আরও বেশি লস হ্রাস এবং উচ্চতর নির্ভুলতা দেয় ।

সাপোর্ট: এটি সমান্তরাল, বিতরণকৃত এবং GPU লার্নিং সমর্থন করে এবং বড় আকারের ডেটা পরিচালনা করতে সক্ষম।

ওভারফিটিং: লিফ-ওয়াইজ বৃদ্ধি দ্রুত হলেও, এটি ওভারফিটিং-এর ঝুঁকি বাড়াতে পারে, যা max_depth প্যারামিটার দ্বারা নিয়ন্ত্রণ করা যায়।

কখন ব্যবহার করবেন: LightGBM অত্যন্ত দ্রুত প্রশিক্ষণের জন্য উপযুক্ত, বিশেষ করে যখন বিশাল ডেটাসেট নিয়ে কাজ করা হয় এবং প্রশিক্ষণের সময় বাঁচানো একটি গুরুত্বপূর্ণ বিষয় । XGBoost সাধারণত LightGBM-এর চেয়ে বেশি শক্তিশালী মডেল তৈরি করতে সক্ষম বলে বিবেচিত হয় । আপনার কাছে থাকা প্রসেসিং ইউনিট (CPU বনাম GPU) এবং গতি বনাম মডেলের দৃঢ়তার (robustness) উপর ভিত্তি করে এই দুটির মধ্যে একটি বেছে নেওয়া যেতে পারে।

Gradient Boosting Classifier মেশিন লার্নিং-এর একটি শক্তিশালী এবং বহুমুখী এনসেম্বল কৌশল, যা বিশেষ করে ক্লাসিফিকেশন এবং রিগ্রেশন সমস্যা সমাধানে উচ্চ নির্ভুলতা প্রদান করে। এটি দুর্বল মডেলগুলির (সাধারণত ডিসিশন ট্রি) একটি ক্রমিক সমন্বয়ের মাধ্যমে কাজ করে, যেখানে প্রতিটি নতুন মডেল পূর্ববর্তী মডেলগুলির দ্বারা করা ভুলগুলিকে লস ফাংশনের গ্রেডিয়েন্ট ব্যবহার করে সংশোধন করে। এই গাণিতিকভাবে চালিত ত্রুটি সংশোধন প্রক্রিয়াটি GBC-কে ডেটার জটিল প্যাটার্নগুলি কার্যকরভাবে শিখতে সক্ষম করে তোলে।

পরিশেষে, যখন সর্বোচ্চ নির্ভুলতা প্রয়োজন এবং মডেলের টিউনিং ও প্রশিক্ষণের জন্য প্রয়োজনীয় সংস্থান উপলব্ধ থাকে, তখন Gradient Boosting Classifier একটি চমৎকার পছন্দ। এর শক্তিশালী কর্মক্ষমতা এবং অভিযোজনযোগ্যতা এটিকে মেশিন লার্নিং অনুশীলনকারীদের টুলকিটে একটি অপরিহার্য সরঞ্জাম করে তুলেছে, যা বিভিন্ন বাস্তব-বিশ্বের অ্যাপ্লিকেশনগুলিতে মূল্যবান অবদান রাখছে।

Leave a Comment