মেশিন লার্নিং-এর জগতে ডিসিশন ট্রি (Decision Tree) একটি জনপ্রিয় এবং শক্তিশালী অ্যালগরিদম। এটি সহজবোধ্য, ব্যাখ্যাযোগ্য এবং ক্লাসিফিকেশন (Classification) ও রিগ্রেশন (Regression) উভয় সমস্যার জন্য ব্যবহৃত হয়।

কৃত্রিম বুদ্ধিমত্তা এবং মেশিন লার্নিং-এর নতুনদের জন্য ডিসিশন ট্রি কীভাবে কাজ করে, এর সুবিধা-অসুবিধা কী, কখন এটি ব্যবহার করা উচিত এবং ওভারফিটিং কীভাবে মোকাবেলা করা যায়, তা নিয়ে আজ আমরা আলোচনা করব।

ডিসিশন ট্রি (Decision Tree) কী?

একটি ডিসিশন ট্রি হলো একটি ফ্লোচার্ট-সদৃশ ট্রি স্ট্রাকচার, যেখানে প্রতিটি অভ্যন্তরীণ নোড (Internal Node) একটি বৈশিষ্ট্যের (Feature) উপর একটি পরীক্ষা (Test) প্রতিনিধিত্ব করে, প্রতিটি শাখা (Branch) পরীক্ষার ফলাফলকে প্রতিনিধিত্ব করে এবং প্রতিটি লিফ নোড (Leaf Node) একটি শ্রেণীর লেবেল (Class Label) বা একটি সংখ্যাসূচক মান (Numerical Value) প্রতিনিধিত্ব করে। এটি মানুষের সিদ্ধান্ত গ্রহণের প্রক্রিয়ার মতো কাজ করে, যেখানে একটি সমস্যার সমাধানের জন্য ধাপে ধাপে প্রশ্ন করা হয়।

সহজ কথায়, আপনি যদি কোনো সিদ্ধান্ত নিতে চান, তবে আপনি কয়েকটি প্রশ্ন করেন এবং প্রতিটি প্রশ্নের উত্তরের উপর ভিত্তি করে পরবর্তী প্রশ্নে যান, যতক্ষণ না আপনি একটি চূড়ান্ত সিদ্ধান্তে পৌঁছান। ডিসিশন ট্রি ঠিক এই নীতি অনুসরণ করে।

ডিসিশন ট্রি (Decision Tree) অ্যালগরিদম: একটি বাস্তব উদাহরণসহ ব্যাখ্যা

মেশিন লার্নিং-এর জগতে ডিসিশন ট্রি একটি অত্যন্ত কার্যকর এবং সহজবোধ্য অ্যালগরিদম। এটি মূলত শ্রেণীবিন্যাস (classification) এবং অনুমান (regression) সমস্যার সমাধানে ব্যবহৃত হয়। পূর্ববর্তী আলোচনায় আমরা ডিসিশন ট্রি-এর মূল ধারণা, স্প্লিটিং ক্রাইটেরিয়া (যেমন গিনি ইম্পিউরিটি ও এন্ট্রপি) এবং ওভারফিটিং নিয়ে কথা বলেছি। এখন আমরা একটি সহজ উদাহরণ এর মাধ্যমে দেখব, কিভাবে একটি ডিসিশন ট্রি কাজ করে।

ধরুন, আমরা একটি কোম্পানির কর্মীদের পদোন্নতি (Promotion) পাওয়ার সম্ভাবনা নিয়ে গবেষণা করছি। আমাদের কাছে কর্মীদের কিছু ডেটা আছে:

- অভিজ্ঞতা (Experience): কম, মাঝারি, বেশি

- শিক্ষাগত যোগ্যতা (Education): স্নাতক, স্নাতকোত্তর, ডক্টরেট

- প্রকল্পের সংখ্যা (Projects): ১-৩, ৪-৬, ৭+

- পদোন্নতি (Promotion): হ্যাঁ/না (এটি আমাদের টার্গেট ভ্যারিয়েবল)

আমাদের লক্ষ্য হলো, এই ডেটা ব্যবহার করে একটি ডিসিশন ট্রি তৈরি করা যা নতুন কর্মীদের ডেটার ভিত্তিতে তাদের পদোন্নতি হবে কিনা তা অনুমান করতে পারবে। ডেটাসেট (উদাহরণস্বরূপ):

| কর্মী আইডি | অভিজ্ঞতা | শিক্ষাগত যোগ্যতা | প্রকল্পের সংখ্যা | পদোন্নতি |

| 1 | কম | স্নাতক | ১-৩ | না |

| 2 | মাঝারি | স্নাতক | ১-৩ | না |

| 3 | মাঝারি | স্নাতকোত্তর | ৪-৬ | হ্যাঁ |

| 4 | বেশি | স্নাতকোত্তর | ৪-৬ | হ্যাঁ |

| 5 | কম | স্নাতক | ৭+ | না |

| 6 | বেশি | ডক্টরেট | ৭+ | হ্যাঁ |

| 7 | মাঝারি | স্নাতক | ৪-৬ | না |

| 8 | কম | স্নাতকোত্তর | ১-৩ | না |

| 9 | বেশি | স্নাতক | ৪-৬ | হ্যাঁ |

| 10 | মাঝারি | ডক্টরেট | ৭+ | হ্যাঁ |

ডিসিশন ট্রি তৈরির প্রক্রিয়া (ধাপে ধাপে)

একটি ডিসিশন ট্রি তৈরির মূল ধারণা হলো, ডেটাকে এমনভাবে ভাগ করা যাতে প্রতিটি ভাগের ডেটা পয়েন্টগুলো একই শ্রেণীর (যেমন, “পদোন্নতি: হ্যাঁ” বা “পদোন্নতি: না”) হয়, বা যতটা সম্ভব একই শ্রেণীর কাছাকাছি থাকে। এর জন্য আমরা গিনি ইম্পিউরিটি (Gini Impurity) ব্যবহার করব, কারণ এটি একটি সহজ এবং কার্যকর মেট্রিক।

স্টেপ ১: রুট নোড (Root Node) নির্বাচন

প্রথমে, আমরা দেখব কোন বৈশিষ্ট্য (Feature) ডেটাকে সবচেয়ে ভালোভাবে ভাগ করতে পারে। অর্থাৎ, কোন বৈশিষ্ট্য ব্যবহার করলে গিনি ইম্পিউরিটি সবচেয়ে বেশি কমে আসে।

আমাদের সম্পূর্ণ ডেটাসেটে মোট ১০ জন কর্মী আছে।

- “পদোন্নতি: হ্যাঁ” = ৫ জন

- “পদোন্নতি: না” = ৫ জন

রুট নোডের গিনি ইম্পিউরিটি হবে: (সর্বোচ্চ ইম্পিউরিটি)

এখন, প্রতিটি বৈশিষ্ট্যের জন্য সম্ভাব্য বিভাজনগুলো দেখব:

ক. ‘অভিজ্ঞতা’ বৈশিষ্ট্য দ্বারা বিভাজন:

- অভিজ্ঞতা: কম (কর্মী ১, ৫, ৮)

- হ্যাঁ: ০, না: ৩

- গিনি ইম্পিউরিটি:

- অভিজ্ঞতা: মাঝারি (কর্মী ২, ৩, ৭, ১০)

- হ্যাঁ: ২, না: ২

- গিনি ইম্পিউরিটি:

- অভিজ্ঞতা: বেশি (কর্মী ৪, ৬, ৯)

- হ্যাঁ: ৩, না: ০

- গিনি ইম্পিউরিটি:

এই বিভাজনগুলোর ওয়েটেড গিনি ইম্পিউরিটি গণনা করা হয়।

খ. ‘শিক্ষাগত যোগ্যতা’ বৈশিষ্ট্য দ্বারা বিভাজন:

- শিক্ষাগত যোগ্যতা: স্নাতক (কর্মী ১, ২, ৫, ৭, ৯)

- হ্যাঁ: ১, না: ৪

- গিনি ইম্পিউরিটি:

- শিক্ষাগত যোগ্যতা: স্নাতকোত্তর (কর্মী ৩, ৪, ৮)

- হ্যাঁ: ২, না: ১

- গিনি ইম্পিউরিটি:

- শিক্ষাগত যোগ্যতা: ডক্টরেট (কর্মী ৬, ১০)

- হ্যাঁ: ২, না: ০

- গini ইম্পিউরিটি:

গ. ‘প্রকল্পের সংখ্যা’ বৈশিষ্ট্য দ্বারা বিভাজন:

- প্রকল্পের সংখ্যা: ১-৩ (কর্মী ১, ২, ৮)

- হ্যাঁ: ০, না: ৩

- গিনি ইম্পিউরিটি:

- প্রকল্পের সংখ্যা: ৪-৬ (কর্মী ৩, ৪, ৭, ৯)

- হ্যাঁ: ৩, না: ১

- গিনি ইম্পিউরিটি:

- প্রকল্পের সংখ্যা: ৭+ (কর্মী ৫, ৬, ১০)

- হ্যাঁ: ২, না: ১

- গিনি ইম্পিউরিটি:

গণনার পর, আমরা দেখব ‘অভিজ্ঞতা’ বৈশিষ্ট্যটি সবচেয়ে বেশি গিনি ইম্পিউরিটি হ্রাস করে (বা ইনফরমেশন গেইন সবচেয়ে বেশি দেয়)। তাই, ‘অভিজ্ঞতা’ হবে আমাদের রুট নোড।

স্টেপ ২: শাখা তৈরি এবং উপ-নোড গঠন

‘অভিজ্ঞতা’ বৈশিষ্ট্যের তিনটি শাখা হবে: কম, মাঝারি, বেশি।

- অভিজ্ঞতা: কম () → এই লিফ নোডের সবাই “পদোন্নতি: না”। এটি একটি বিশুদ্ধ নোড (Pure Node)।

- অভিজ্ঞতা: বেশি () → এই লিফ নোডের সবাই “পদোন্নতি: হ্যাঁ”। এটিও একটি বিশুদ্ধ নোড (Pure Node)।

- অভিজ্ঞতা: মাঝারি () → এই নোডটি এখনও বিশুদ্ধ নয় (২ জন “হ্যাঁ”, ২ জন “না”)। তাই এই নোড থেকে আরও বিভাজন করতে হবে।

স্টেপ ৩: ‘অভিজ্ঞতা: মাঝারি’ নোড থেকে further বিভাজন

এখন আমরা শুধু ‘অভিজ্ঞতা: মাঝারি’ সাব-ডেটাসেট (কর্মী ২, ৩, ৭, ১০) নিয়ে কাজ করব।

| কর্মী আইডি | অভিজ্ঞতা | শিক্ষাগত যোগ্যতা | প্রকল্পের সংখ্যা | পদোন্নতি |

| 2 | মাঝারি | স্নাতক | ১-৩ | না |

| 3 | মাঝারি | স্নাতকোত্তর | ৪-৬ | হ্যাঁ |

| 7 | মাঝারি | স্নাতক | ৪-৬ | না |

| 10 | মাঝারি | ডক্টরেট | ৭+ | হ্যাঁ |

আবারো, এই ৪ জন কর্মীর মধ্যে কোন বৈশিষ্ট্যটি সবচেয়ে ভালোভাবে ভাগ করতে পারে, তা পরীক্ষা করব।

ক. ‘শিক্ষাগত যোগ্যতা’ দ্বারা বিভাজন:

- স্নাতক (কর্মী ২, ৭)

- হ্যাঁ: ০, না: ২

- গিনি ইম্পিউরিটি:

- স্নাতকোত্তর (কর্মী ৩)

- হ্যাঁ: ১, না: ০

- গিনি ইম্পিউরিটি:

- ডক্টরেট (কর্মী ১০)

- হ্যাঁ: ১, না: ০

- গিনি ইম্পিউরিটি:

এই বিভাজনটি সম্পূর্ণ বিশুদ্ধ নোড তৈরি করে।

খ. ‘প্রকল্পের সংখ্যা’ দ্বারা বিভাজন:

- ১-৩ (কর্মী ২)

- হ্যাঁ: ০, না: ১

- গিনি ইম্পিউরিটি:

- ৪-৬ (কর্মী ৩, ৭)

- হ্যাঁ: ১, না: ১

- গিনি ইম্পিউরিটি:

- ৭+ (কর্মী ১০)

- হ্যাঁ: ১, না: ০

- গিনি ইম্পিউরিটি:

দেখা যাচ্ছে, ‘শিক্ষাগত যোগ্যতা’ বৈশিষ্ট্যটি ‘অভিজ্ঞতা: মাঝারি’ নোডটিকে পুরোপুরি বিশুদ্ধ উপসেটে ভাগ করতে পারে। তাই ‘অভিজ্ঞতা: মাঝারি’ নোডের পরবর্তী বিভাজন হবে ‘শিক্ষাগত যোগ্যতা’ অনুযায়ী। এর ফলে আমাদের ডিসিশন ট্রি-টি দেখতে অনেকটা নিচের মতো হবে:

|

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 |

অভিজ্ঞতা? / | \ / | \ / | \ কম মাঝারি বেশি / | \ না শিক্ষাগত যোগ্যতা? হ্যাঁ / | \ / | \ / | \ স্নাতক স্নাতকোত্তর ডক্টরেট / | \ না হ্যাঁ হ্যাঁ |

এই ট্রি ব্যবহার করে আমরা এখন যেকোনো নতুন কর্মীর পদোন্নতি পাওয়ার সম্ভাবনা অনুমান করতে পারি।

ডিসিশন ট্রি (Decision Tree) কীভাবে কাজ করে?

ডিসিশন ট্রি একটি পুনরাবৃত্তিমূলক (Recursive) প্রক্রিয়া ব্যবহার করে ডেটাসেটকে ছোট ছোট উপসেটে বিভক্ত করে, যতক্ষণ না উপসেটগুলি প্রায় বিশুদ্ধ (Pure) হয়। একটি উপসেট বিশুদ্ধ মানে হলো, সেই উপসেটের সমস্ত ডেটা পয়েন্ট একই শ্রেণীর অন্তর্গত। এই বিভাজন প্রক্রিয়াটি একটি “টপ-ডাউন” পদ্ধতিতে ঘটে, যেখানে রুট নোড থেকে শুরু করে ট্রি-টি নিচের দিকে বাড়তে থাকে।

প্রতিটি নোডে, অ্যালগরিদম এমন একটি বৈশিষ্ট্য খুঁজে বের করে যা ডেটা সেটকে সবচেয়ে ভালোভাবে বিভক্ত করতে পারে। এই “সবচেয়ে ভালোভাবে” বিভক্ত করার জন্য কিছু মানদণ্ড ব্যবহার করা হয়, যা “স্প্লিটিং ক্রাইটেরিয়া” (Splitting Criteria) নামে পরিচিত।

স্প্লিটিং ক্রাইটেরিয়া: গিনি ইম্পিউরিটি (Gini Impurity) এবং এন্ট্রপি (Entropy)

একটি ডিসিশন ট্রি তৈরির সময়, কোন বৈশিষ্ট্যটি ডেটা বিভাজনের জন্য সবচেয়ে ভালো, তা নির্ধারণ করার জন্য কিছু মেট্রিক ব্যবহার করা হয়। দুটি প্রধান মেট্রিক হলো:

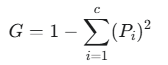

১. গিনি ইম্পিউরিটি (Gini Impurity): এটি একটি নোডের বিশুদ্ধতা পরিমাপ করে। যদি একটি নোডের সমস্ত ডেটা পয়েন্ট একই শ্রেণীর হয়, তাহলে গিনি ইম্পিউরিটি ০ (শূন্য) হয়, যা সর্বোচ্চ বিশুদ্ধতা নির্দেশ করে। এটি একটি নোডে এলোমেলোভাবে নির্বাচিত দুটি ডেটা পয়েন্টের ভিন্ন শ্রেণীর হওয়ার সম্ভাবনা পরিমাপ করে।

গিনি ইম্পিউরিটির সূত্রটি নিম্নরূপ:

যেখানে হলো শ্রেণীর সংখ্যা এবং হলো একটি নির্দিষ্ট শ্রেণীর ডেটা পয়েন্টের অনুপাত।

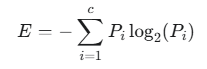

২. এন্ট্রপি (Entropy): এটি একটি নোডে ডেটার এলোমেলোতা (Randomness) বা অনিশ্চয়তা (Uncertainty) পরিমাপ করে। যদি একটি নোডের সমস্ত ডেটা পয়েন্ট একই শ্রেণীর হয়, তাহলে এন্ট্রপি ০ হয়, যা সর্বনিম্ন অনিশ্চয়তা নির্দেশ করে। সর্বোচ্চ অনিশ্চয়তা (০.৫) হয় যখন প্রতিটি শ্রেণীর ডেটা পয়েন্ট সমানভাবে বিতরণ করা হয়।

এন্ট্রপির সূত্রটি নিম্নরূপ:

যেখানে হলো শ্রেণীর সংখ্যা এবং হলো একটি নির্দিষ্ট শ্রেণীর ডেটা পয়েন্টের অনুপাত।

অ্যালগরিদম প্রতিটি সম্ভাব্য বিভাজনের জন্য গিনি ইম্পিউরিটি বা এন্ট্রপি গণনা করে এবং সেই বিভাজনটি বেছে নেয় যা ইম্পিউরিটি বা এন্ট্রপিকে সর্বাধিক হ্রাস করে (অর্থাৎ, ইনফরমেশন গেইন (Information Gain) সর্বাধিক করে)।

ওভারফিটিং এবং প্রুনিং (Overfitting and Pruning)

ডিসিশন ট্রি একটি শক্তিশালী অ্যালগরিদম হলেও, এর একটি প্রধান সমস্যা হলো ওভারফিটিং।

ওভারফিটিং (Overfitting): যখন একটি ডিসিশন ট্রি ট্রেনিং ডেটার উপর খুব ভালোভাবে ফিট করে, কিন্তু নতুন, অদেখা ডেটার উপর খারাপ পারফর্ম করে, তখন তাকে ওভারফিটিং বলে। এটি ঘটে যখন ট্রি খুব গভীর হয়ে যায় এবং ট্রেনিং ডেটার নয়েজ (Noise) এবং নির্দিষ্ট বৈশিষ্ট্যগুলিকেও শিখে ফেলে। ওভারফিটিং প্রতিরোধের জন্য “প্রুনিং” (Pruning) একটি গুরুত্বপূর্ণ কৌশল।

প্রুনিং (Pruning): প্রুনিং হলো ট্রি থেকে অতিরিক্ত শাখা বা নোডগুলিকে সরিয়ে ফেলার প্রক্রিয়া। এর ফলে ট্রি সরল হয় এবং জেনারেলাইজেশন (Generalization) ক্ষমতা বৃদ্ধি পায়। প্রুনিং দুই প্রকার হতে পারে:

- প্রি-প্রুনিং (Pre-pruning): ট্রি তৈরির সময়ই এটি করা হয়। ট্রিকে একটি নির্দিষ্ট গভীরতা (Max Depth) পর্যন্ত বাড়তে দেওয়া হয়, বা একটি নির্দিষ্ট সংখ্যক লিফ নোড তৈরি হওয়ার পর ট্রি তৈরি বন্ধ করা হয়।

- পোস্ট-প্রুনিং (Post-pruning): প্রথমে একটি সম্পূর্ণ ট্রি তৈরি করা হয়, তারপর অপ্রয়োজনীয় শাখাগুলিকে ছাঁটাই করা হয়।

পাইথন ব্যবহার করে ডিসিশন ট্রি (Decision Tree) এর উদাহরণ

চলুন, একটি সহজ উদাহরণ দিয়ে দেখি পাইথনে ডিসিশন ট্রি কিভাবে কাজ করে। আমরা scikit-learn লাইব্রেরি ব্যবহার করব।

|

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 76 77 78 79 80 81 |

import pandas as pd from sklearn.tree import DecisionTreeClassifier, plot_tree from sklearn.model_selection import train_test_split from sklearn.preprocessing import LabelEncoder from sklearn.metrics import accuracy_score import matplotlib.pyplot as plt # ডেটাসেট তৈরি করা (উপরের উদাহরণ অনুযায়ী) data = { 'কর্মী আইডি': [1, 2, 3, 4, 5, 6, 7, 8, 9, 10], 'অভিজ্ঞতা': ['কম', 'মাঝারি', 'মাঝারি', 'বেশি', 'কম', 'বেশি', 'মাঝারি', 'কম', 'বেশি', 'মাঝারি'], 'শিক্ষাগত যোগ্যতা': ['স্নাতক', 'স্নাতক', 'স্নাতকোত্তর', 'স্নাতকোত্তর', 'স্নাতক', 'ডক্টরেট', 'স্নাতক', 'স্নাতকোত্তর', 'স্নাতক', 'ডক্টরেট'], 'প্রকল্পের সংখ্যা': ['১-৩', '১-৩', '৪-৬', '৪-৬', '৭+', '৭+', '৪-৬', '১-৩', '৪-৬', '৭+'], 'পদোন্নতি': ['না', 'না', 'হ্যাঁ', 'হ্যাঁ', 'না', 'হ্যাঁ', 'না', 'না', 'হ্যাঁ', 'হ্যাঁ'] } df = pd.DataFrame(data) # ক্যাটেগরিক্যাল ডেটাকে সংখ্যায় রূপান্তর (Label Encoding) # ডিসিশন ট্রি সরাসরি স্ট্রিং ডেটা নিয়ে কাজ করতে পারে না, তাই এনকোড করতে হবে le = LabelEncoder() for column in ['অভিজ্ঞতা', 'শিক্ষাগত যোগ্যতা', 'প্রকল্পের সংখ্যা', 'পদোন্নতি']: df[column] = le.fit_transform(df[column]) # ফিচার এবং টার্গেট ভ্যারিয়েবল আলাদা করা X = df[['অভিজ্ঞতা', 'শিক্ষাগত যোগ্যতা', 'প্রকল্পের সংখ্যা']] y = df['পদোন্নতি'] # ডেটাসেটকে ট্রেনিং এবং টেস্টিং সেটে ভাগ করা (ছোট ডেটাসেট হওয়ায় টেস্টিং সেট ছোট রাখা হয়েছে) X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42) # ডিসিশন ট্রি মডেল তৈরি করা # criterion='gini' হলো গিনি ইম্পিউরিটি ব্যবহার করবে # max_depth=3 দিয়ে আমরা ট্রি-এর গভীরতা ৩ এ সীমাবদ্ধ রাখছি, ওভারফিটিং কমাতে dtree = DecisionTreeClassifier(criterion='gini', max_depth=3, random_state=42) # মডেলকে ট্রেনিং ডেটা দিয়ে প্রশিক্ষণ দেওয়া dtree.fit(X_train, y_train) # টেস্ট ডেটার উপর পূর্বাভাস তৈরি করা y_pred = dtree.predict(X_test) # মডেলের নির্ভুলতা মূল্যায়ন করা accuracy = accuracy_score(y_test, y_pred) print(f"মডেলের নির্ভুলতা: {accuracy:.2f}") # ডিসিশন ট্রি ভিজ্যুয়ালাইজ করা plt.figure(figsize=(12,8)) plot_tree(dtree, filled=True, feature_names=X.columns, class_names=['না', 'হ্যাঁ'], rounded=True) plt.title("Decision Tree Visualization for Promotion Prediction") plt.show() # একটি নতুন ডেটা পয়েন্টের জন্য পূর্বাভাস # নতুন কর্মী: অভিজ্ঞতা: মাঝারি, শিক্ষাগত যোগ্যতা: স্নাতক, প্রকল্পের সংখ্যা: ৪-৬ # প্রথমে ডেটাটিকে সংখ্যায় রূপান্তর করতে হবে new_employee_data = pd.DataFrame({ 'অভিজ্ঞতা': ['মাঝারি'], 'শিক্ষাগত যোগ্যতা': ['স্নাতক'], 'প্রকল্পের সংখ্যা': ['৪-৬'] }) # প্রতিটা ফিচারের জন্য সংশ্লিষ্ট LabelEncoder ব্যবহার করে এনকোড করতে হবে # এই অংশটা সঠিকভাবে চালানোর জন্য প্রতিটি কলামের জন্য আলাদা LabelEncoder ইনস্ট্যান্স তৈরি করা উচিত, অথবা পূর্বের fit_transform এর সময় ব্যবহৃত encoder গুলিকে সংরক্ষণ করা উচিত। # এখানে একটি সরলীকৃত উদাহরণ দেখানো হলো, যেখানে অনুমান করা হয়েছে যে এনকোডারগুলো সঠিকভাবে মানগুলোকে রূপান্তর করতে পারবে। # অভিজ্ঞতার জন্য: 'কম': 0, 'মাঝারি': 1, 'বেশি': 2 # শিক্ষাগত যোগ্যতার জন্য: 'ডক্টরেট': 0, 'স্নাতক': 1, 'স্নাতকোত্তর': 2 # প্রকল্পের সংখ্যার জন্য: '১-৩': 0, '৪-৬': 1, '৭+': 2 # এই এনকোডিংগুলি পূর্ববর্তী df এর fit_transform এর উপর নির্ভরশীল। # সঠিক ফলাফলের জন্য, প্রতিটি কলামের জন্য ব্যবহৃত encoder এর mapping জানা প্রয়োজন। # ধরে নিচ্ছি এনকোডিং সঠিকভাবে হয়েছে: # 'মাঝারি' অভিজ্ঞতা -> 1 # 'স্নাতক' শিক্ষাগত যোগ্যতা -> 1 # '৪-৬' প্রকল্পের সংখ্যা -> 1 encoded_new_data = [[1, 1, 1]] # আনুমানিক এনকোডেড ডেটা predicted_promotion = dtree.predict(encoded_new_data) class_names = ['না', 'হ্যাঁ'] print(f"নতুন কর্মীর পূর্বাভাসিত পদোন্নতি: {class_names[predicted_promotion[0]]}") |

উপরের কোডে আমরা প্রথমে একটি Pandas DataFrame তৈরি করেছি আমাদের উদাহরণ ডেটা দিয়ে। যেহেতু scikit-learn সরাসরি স্ট্রিং ডেটা নিয়ে কাজ করতে পারে না, তাই আমরা LabelEncoder ব্যবহার করে ক্যাটেগরিক্যাল ডেটাগুলিকে সংখ্যায় রূপান্তর করেছি।

এরপর, ডেটাকে ট্রেনিং ও টেস্টিং সেটে ভাগ করে একটি DecisionTreeClassifier তৈরি ও প্রশিক্ষণ দিয়েছি। max_depth=3 সেট করে আমরা ওভারফিটিং কিছুটা কমিয়েছি এবং ট্রিটিকে আরও ব্যাখ্যাযোগ্য করেছি। অবশেষে, মডেলের নির্ভুলতা পরিমাপ করা হয়েছে এবং plot_tree ফাংশন ব্যবহার করে ট্রি-এর চিত্র দেখানো হয়েছে। নতুন কর্মীর ডেটার উপর ভিত্তি করে পদোন্নতির পূর্বাভাসও করা হয়েছে।

ডিসিশন ট্রি (Decision Tree) এর সুবিধা:

- সহজবোধ্য এবং ব্যাখ্যাযোগ্য: ডিসিশন ট্রি-এর গঠন একটি ফ্লোচার্টের মতো হওয়ায়, এর সিদ্ধান্ত গ্রহণ প্রক্রিয়া বোঝা এবং ব্যাখ্যা করা খুব সহজ। আপনি সহজেই দেখতে পারবেন কেন মডেল একটি নির্দিষ্ট সিদ্ধান্ত নিয়েছে।

- ডেটা প্রস্তুতির কম প্রয়োজন: অন্যান্য কিছু অ্যালগরিদমের মতো ডেটা স্কেলিং বা নরম্যালাইজেশনের মতো ব্যাপক প্রিপ্রসেসিং সাধারণত প্রয়োজন হয় না। এটি সংখ্যাসূচক এবং ক্যাটেগরিক্যাল উভয় প্রকারের ডেটা নিয়ে কাজ করতে পারে।

- ফিচার নির্বাচনের ক্ষমতা: ডিসিশন ট্রি স্বয়ংক্রিয়ভাবে ডেটার সবচেয়ে গুরুত্বপূর্ণ ফিচারগুলি চিহ্নিত করতে পারে যা সিদ্ধান্ত গ্রহণে সবচেয়ে বেশি সহায়ক।

- সংখ্যাসূচক এবং ক্যাটেগরিক্যাল ডেটা হ্যান্ডেল করতে পারে: উভয় প্রকারের ডেটা নিয়ে কাজ করতে পারে।

- নন-লিনিয়ার সম্পর্ক হ্যান্ডেল করতে পারে: এটি ডেটার মধ্যেকার জটিল, নন-লিনিয়ার সম্পর্কগুলিকে কার্যকরভাবে ধরতে পারে।

ডিসিশন ট্রি (Decision Tree) এর অসুবিধা:

- ওভারফিটিং প্রবণতা: ডিসিশন ট্রি-এর প্রধান দুর্বলতা হলো এটি ট্রেনিং ডেটার উপর খুব ভালোভাবে ফিট করতে পারে, যার ফলে নতুন, অদেখা ডেটার উপর এর পারফরম্যান্স খারাপ হতে পারে। এটি ঘটে যখন ট্রি অতিরিক্ত গভীর হয়ে যায় এবং ট্রেনিং ডেটার নয়েজ (Noise) বা নির্দিষ্ট প্যাটার্নগুলিকেও শিখে ফেলে।

- ভ্যারিয়েন্সের প্রতি সংবেদনশীল: ট্রেনিং ডেটাসেটে সামান্য পরিবর্তনও সম্পূর্ণ ভিন্ন একটি ট্রি তৈরি করতে পারে, যা মডেলের স্থিতিশীলতা কমিয়ে দেয়।

- বায়াস: যদি ট্রেনিং ডেটা ভারসাম্যহীন হয় (যেমন, একটি ক্লাসের ডেটা অন্য ক্লাসের ডেটার চেয়ে অনেক বেশি), তাহলে ট্রিটি সেই প্রভাবশালী ক্লাসের দিকে বায়াসড হতে পারে।

- স্থানীয় অপটিমা (Local Optima): ট্রি তৈরির সময় প্রতিটি ধাপে “গ্রিডি” পদ্ধতি (অর্থাৎ, যে বিভাজনটি সেই মুহূর্তে সবচেয়ে ভালো) ব্যবহার করার কারণে এটি সবসময় বিশ্বব্যাপী সর্বোত্তম (globally optimal) ট্রি খুঁজে নাও পেতে পারে।

ডিসিশন ট্রি (Decision Tree) কখন ব্যবহার করবেন?

- যখন ব্যাখ্যাযোগ্যতা গুরুত্বপূর্ণ: যদি আপনার মডেলের সিদ্ধান্তগুলি কেন নেওয়া হচ্ছে তা বোঝা এবং ব্যাখ্যা করা অপরিহার্য হয় (যেমন, চিকিৎসা বা আর্থিক মডেলিং)।

- ছোট থেকে মাঝারি আকারের ডেটাসেট: যখন আপনার ডেটাসেটের আকার খুব বড় নয়, তখন ডিসিশন ট্রি দ্রুত একটি কার্যকর মডেল দিতে পারে।

- মিক্সড ডেটা প্রকার: যখন আপনার ডেটাসেটে সংখ্যাসূচক এবং ক্যাটেগরিক্যাল উভয় প্রকারের ডেটা থাকে।

- দ্রুত প্রোটোটাইপিং: প্রাথমিক বিশ্লেষণ বা দ্রুত একটি বেসলাইন মডেল তৈরি করার জন্য এটি একটি ভালো বিকল্প।

- ফিচার নির্বাচনের প্রয়োজন: যদি আপনি জানতে চান ডেটার কোন ফিচারগুলি আউটকামকে সবচেয়ে বেশি প্রভাবিত করছে।

ডিসিশন ট্রি অ্যালগরিদম মেশিন লার্নিং-এর একটি মৌলিক এবং গুরুত্বপূর্ণ উপাদান। এর সরলতা, ব্যাখ্যাযোগ্যতা এবং ডেটা প্রস্তুতির কম প্রয়োজনীয়তা এটিকে ডেটা বিজ্ঞানী এবং মেশিন লার্নিং উত্সাহীদের জন্য একটি জনপ্রিয় পছন্দ করে তোলে। ওভারফিটিংয়ের মতো চ্যালেঞ্জগুলি মোকাবেলা করতে প্রুনিং-এর মতো কৌশলগুলি ব্যবহার করে এর কার্যকারিতা আরও উন্নত করা যায়। এই অ্যালগরিদমটি ভালোভাবে বুঝতে পারলে আপনি ডেটা বিশ্লেষণের আরও উন্নত কৌশল যেমন র্যান্ডম ফরেস্ট এবং বুস্টিং অ্যালগরিদমগুলি সহজে বুঝতে পারবেন।

Leave a Comment